2023. 10. 26. 15:23ㆍRun/Machine Learning

Stanford University CS231n, Spring 2017

CS231n: Convolutional Neural Networks for Visual Recognition Spring 2017 http://cs231n.stanford.edu/

www.youtube.com

LeNet

이미지를 input으로 받아 5x5 필터를 거치고 여러 개의 Conv layer와 Pooling layer을 거침

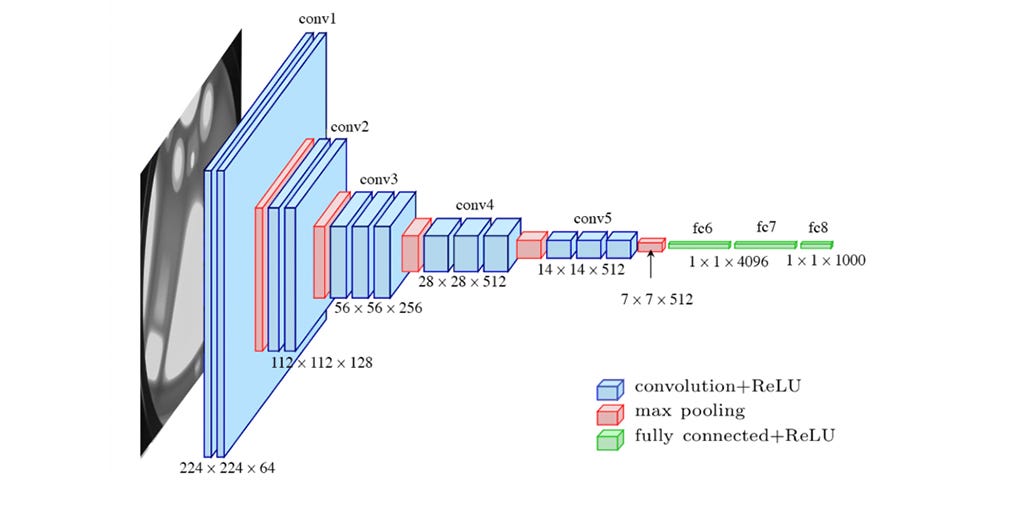

AlexNet

2012년에 Image Classification Benchmark에서 우승한 모델이며, 최초의 large scale CNN임

Conv - Pool - Normalization 구조가 두 번 반복되고, 그 뒤에 Conv layer와 Pooling layer가 더 붙고 마지막에 FC layer가 붙음

Input의 크기는 227 x 227 x 3 임

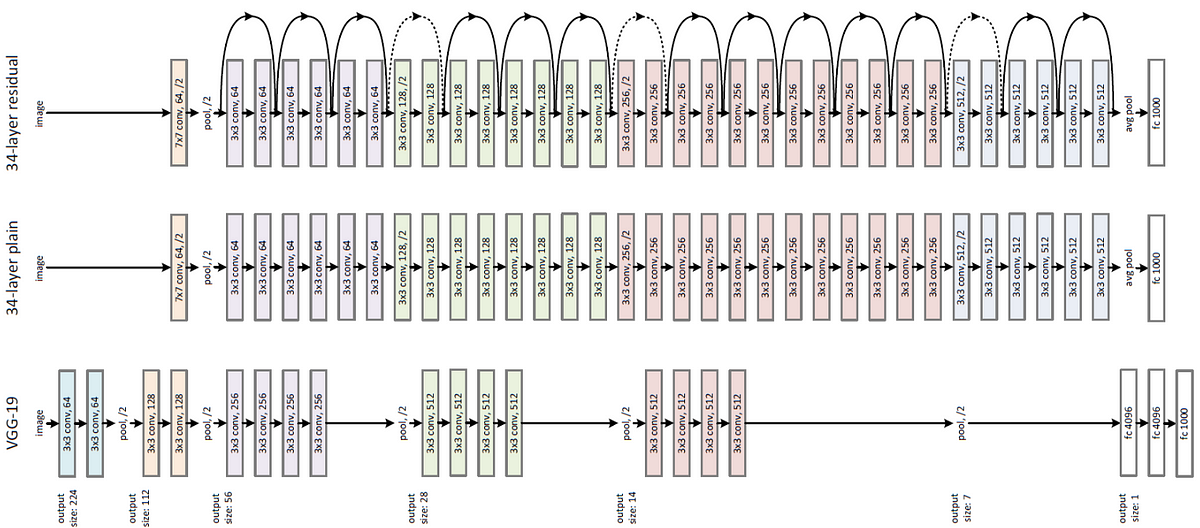

VGGNet

네트워크가 훨씬 더 깊어졌고, 더 작은 filter을 사용함

항상 3x3 filter만 사용하고, 주기적으로 Pooling을 수행함

작은 filter을 사용하면 파라미터 수가 적기 때문에 레이어를 더 많이 쌓을 수 있음 (Depth ↑)

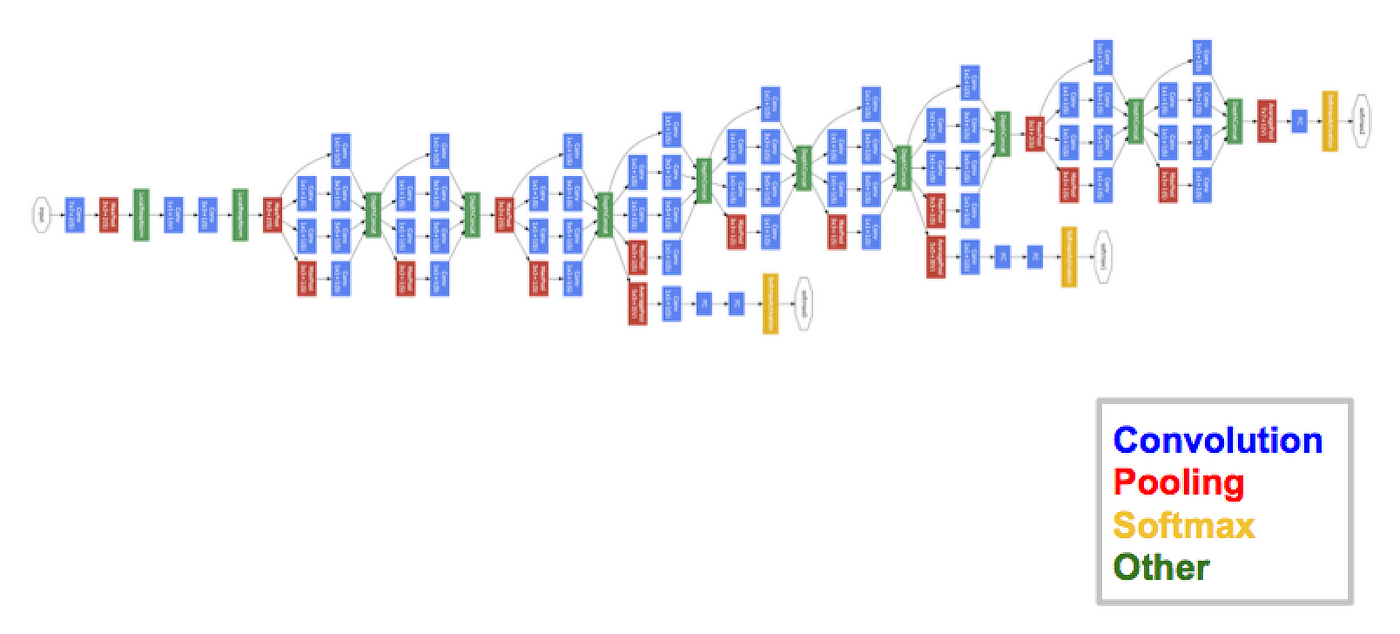

GoogLeNet

2014년 Classification Challenge에서 우승한 모델이며 22개의 레이어로, 깊은 네트워크임

높은 계산량을 효율적으로 수행할 수 있도록 설계됨

Inception module이라는 것을 여러 개 쌓아서 만들며, FC layer를 사용하지 않아 파라미터 수를 줄임 (500만 개)

ResNet

기존의 어떤 네트워크보다도 훨씬 깊은 모델

단순히 레이어를 쌓지 않고(Direct mapping) Residual connection이라는 기법을 사용함

'Run > Machine Learning' 카테고리의 다른 글

| [Machine Learning] CS231N #11 Detection and Segmentation (1) | 2023.10.30 |

|---|---|

| [Machine Learning] CS231N #10 Recurrent Neural Networks (2) | 2023.10.26 |

| [Machine Learning] CS231N #7 Training Neural Networks 2 (0) | 2023.10.17 |

| [Machine Learning] CS231N #6 Training Neural Networks 1 (0) | 2023.10.17 |

| [Machine Learning] CS231N #5 Convolutional Neural Networks (0) | 2023.10.16 |